Thuật ngữ WordPress Robots.txt được sử dụng phổ biến trong lĩnh vực CNTT. Tuy nhiên, đối với những người mới thì thuật ngữ này vẫn khá mới mẻ và còn gặp nhiều khó khăn trong quá trình sử dụng. Trong bài viết dưới đây, chúng tôi sẽ hướng dẫn cho bạn cách sử dụng, tạo và chỉnh sửa file Robots.txt hiệu quả.

WordPress Robots.txt là gì?

Trước khi tìm hiểu về WordPress robots.txt, trước tiên chúng ta hãy cùng tìm hiểu về robot. Robot hay còn gọi là bot có khả năng truy cập vào các Website trên Internet. Chẳng hạn như trình thu thập thông tin và dữ liệu của công cụ tìm kiếm như Google Index hay Google Rank.

Dịch vụ NVMe Hosting WordPress tốc độ cao

BKHOST đang có chương trình khuyến mãi cực tốt dành cho khách hàng đăng ký dịch vụ NVMe Hosting WordPress:

- Giảm giá lên đến

40%

.

- Giá chỉ từ

23k

/tháng.

- Tặng gói bảo mật

SSL Let’s Encrypt

.

Đăng ký ngay:

host wordpress

Vào giữa những năm 1990, để kiểm soát cách robot tương tác với các trang web nên các nhà phát triển đã đề xuất việc loại trừ chúng. Để kiểm soát cách các bot tham gia tương tác với trang web, người dùng có thể lựa chọn sử dụng Robots.txt. Chẳng hạn như chặn hoàn toàn hoặc hạn chế quyền truy cập của chúng.

Bởi vì Robots.txt không thể quản lý các bot làm bất cứ điều gì nên một số bot độc hại xuất hiện trên Website sẽ tự động bỏ qua tệp đó. Đồng thời, một số tổ chức cũng có thể bỏ qua các lệnh có sẵn trong Robots.txt. Chẳng hạn như Google sẽ bỏ qua một vài quy tắc được thêm vào Robots.txt bao gồm các tần suất truy cập của trình thu thập thông tin. Người dùng có thể lựa chọn các giải pháp bảo mật phổ biến như Cloudflare hoặc Sucuri để khắc phục các vấn đề liên quan đến bot.

Lợi ích của file Robots.txt là gì?

File Robots.txt dành cho quản trị viên web có hai lợi ích chính như sau:

- Tệp Robots.txt có khả năng giảm thiểu tình trạng lãng phí thời gian trên các Website không cần thiết. Điều này giúp tối ưu hóa tài nguyên thu thập thông tin và các dữ liệu quan trọng của công cụ tìm kiếm rất hiệu quả.

- Tệp Robots.txt có khả năng tối ưu hóa quá trình sử dụng máy chủ bằng cách ngăn chặn các bot gây lãng phí tài nguyên.

Robots.txt ít khả thi đối với các trang web được lập chỉ mục trong công cụ tìm kiếm:

File Robots.txt không phải là một lựa chọn hoàn hảo dành cho việc kiểm soát trang web tốt. Có thể sử dụng thẻ Meta Noindex hoặc bất kỳ phương pháp nào để ngăn các trang web cụ thể được đưa vào kết quả của công cụ tìm kiếm.

Robots.txt cho phép các công cụ tìm kiếm Index nội dung nhưng yêu cầu chúng không thu thập các dữ liệu có trong nội dung đó. Mặc dù Google không thu thập dữ liệu từ các vị trí ngoài vùng đánh dấu trên trang web, nhưng nó vẫn tiến hành thực hiện Index trang đó nếu nó liên kết với một trang bất kỳ được loại trừ bằng tệp Robots.txt.

John Mueller là nhà phân tích quản trị trang web của Google cho biết một trang vẫn có thể được Index mặc dù có liên kết trỏ bị Robots.txt. Điều này dẫn đến việc một số trang không mong muốn vẫn nằm trong danh sách Index bởi hệ thống sẽ không thể phân biệt được trang web nào khách hàng mong muốn hoặc không được Index.

Trong trường hợp trang web không bị Robots.txt chặn thì bạn có thể sử dụng thẻ Meta Noindex. Điều này sẽ giúp cho hệ thống nhận biết được trang nào không cần Index và có thể bỏ qua chúng.

Hướng dẫn tạo và chỉnh sửa file WordPress Robots.txt

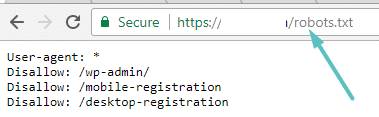

WordPress được cài đặt chế độ tạo tệp Robots.txt ảo tự động cho Website. Thêm “/robots.txt” vào cuối tên miền để tiến hành kiểm tra tệp của mình. Ví dụ, thêm “/robots.txt” vào tên miền “https://bkhost.com/robots.txt” hiển thị tệp robots.txt trên Bkhost.

Đây là một tệp ảo nên người dùng không thể chỉnh sửa nó. Vì thế, để chỉnh sửa tệp robots.txt này thì người dùng sẽ phải tạo thêm một tệp vật lý mới ở trên máy chủ.

Tạo và chỉnh sửa file Robots.txt với Yoast SEO

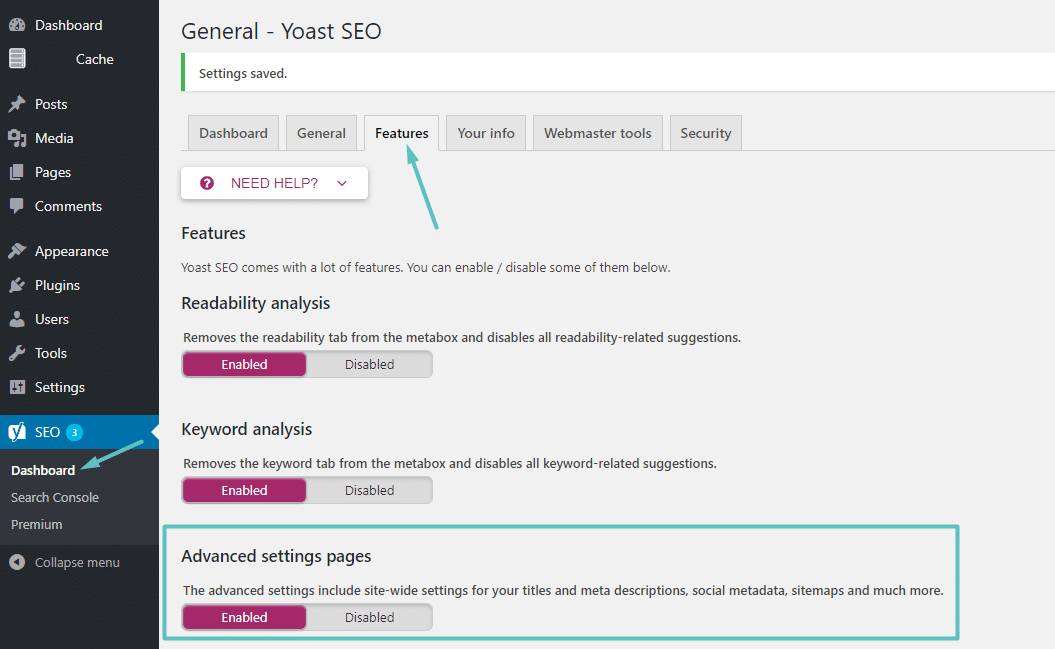

Để truy cập vào Yoast SEO để tạo và chỉnh sửa tệp robots.txt, trước tiên cần bật các tính năng nâng cao bằng cách thực hiện các thao tác như sau SEO → Dashboard → Features and toggling on Advanced settings pages:

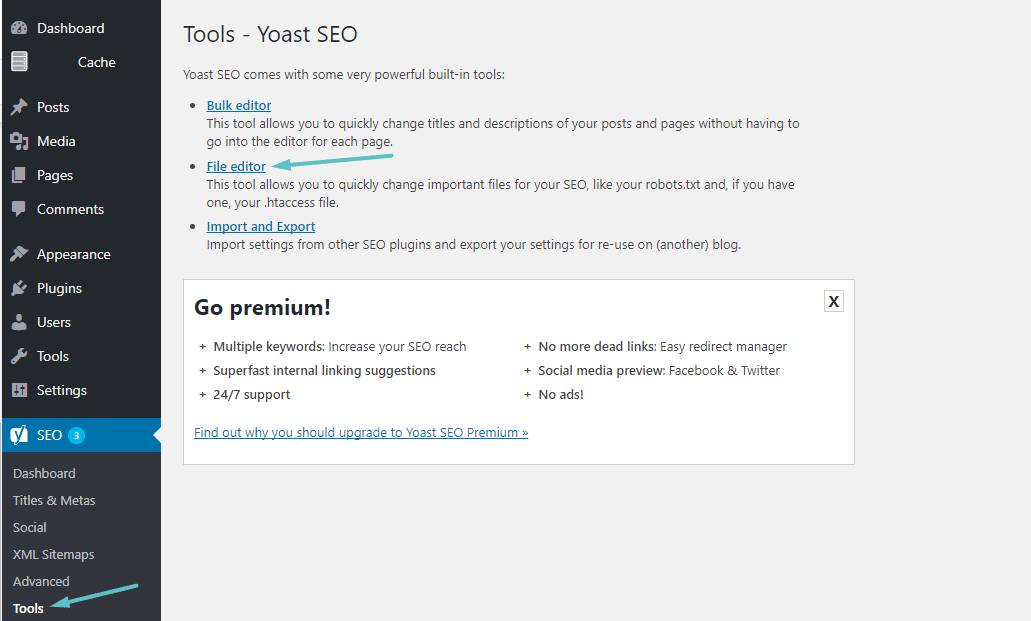

Sau khi đã kích hoạt thành công, tiếp tục lựa chọn các mục SEO → Tools → File editor:

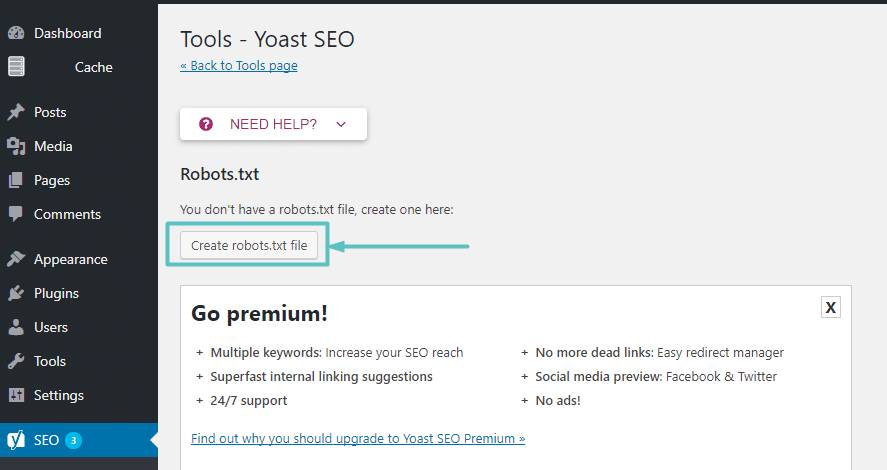

Trong trường hợp máy chủ chưa tồn tại bất cứ tệp Robots.txt vật lý nào thì Yoast sẽ cung cấp tùy chọn Create robots.txt file:

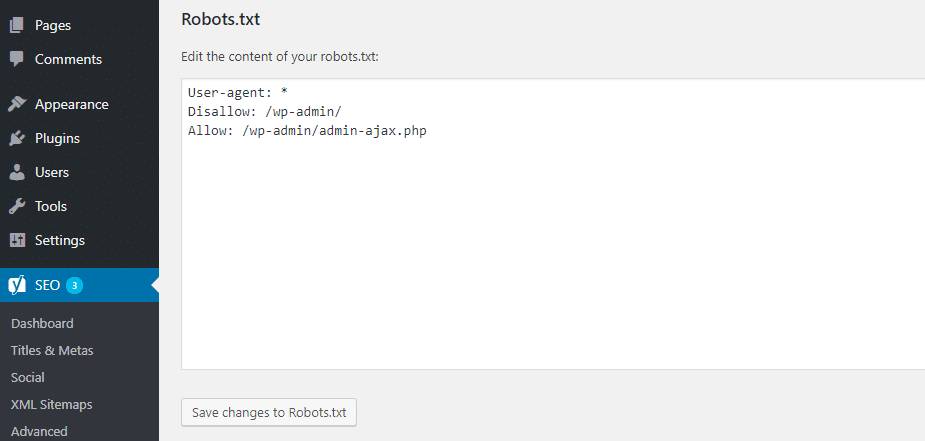

Nhấn chọn vào mục Create robots.txt file để chỉnh sửa nội dung của tệp Robots.txt trực tiếp trên cùng một giao diện:

Tạo và chỉnh sửa file Robots.txt với All in One SEO

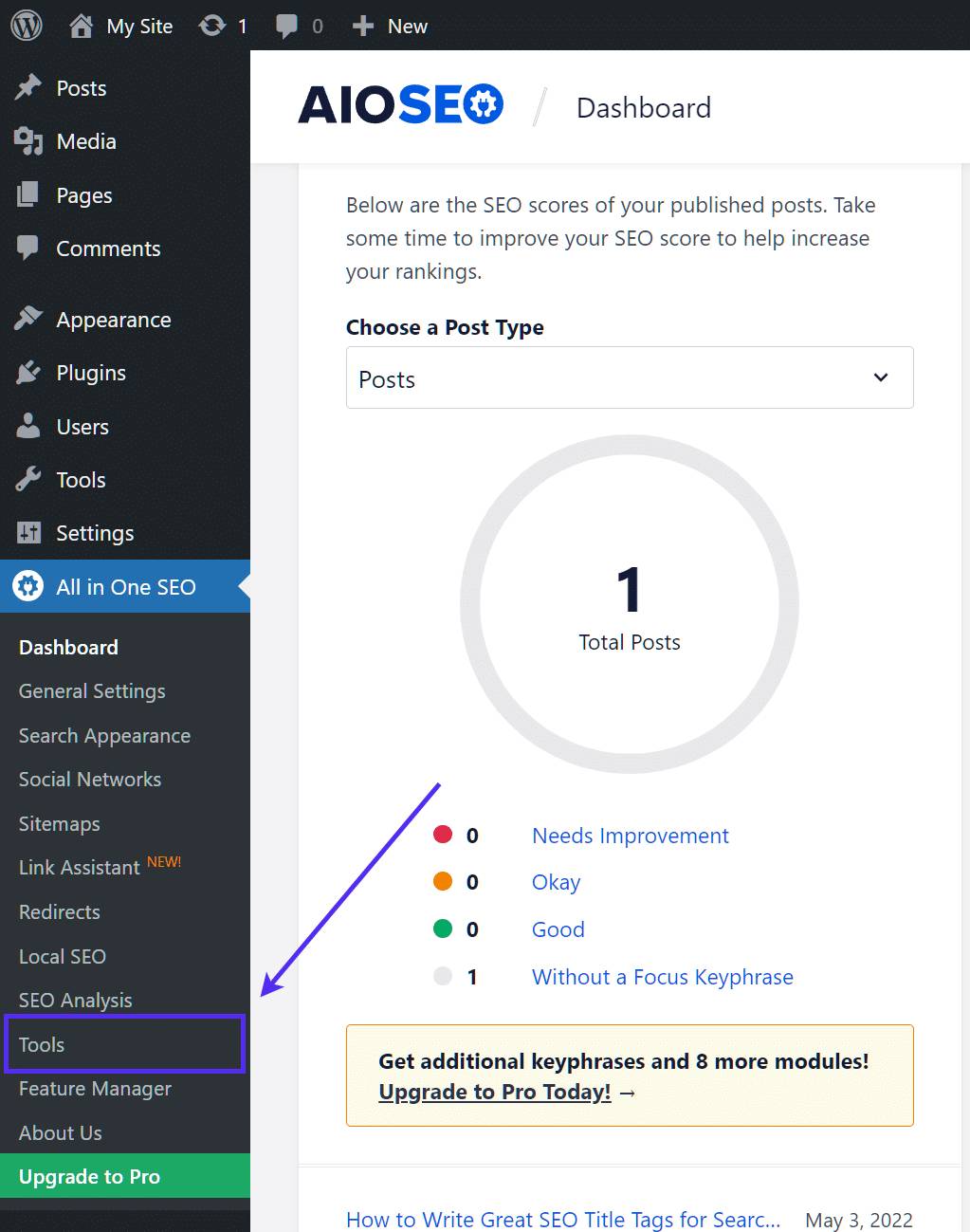

Tương tự như cách thực thi tệp với Yoast, plugin All in One SEO Pack có khả năng hỗ trợ người dùng tạo và chỉnh sửa tệp Robot.txt WordPress hiệu quả. Để kích hoạt công cụ này, hãy đi tới All in One SEO → Tools:

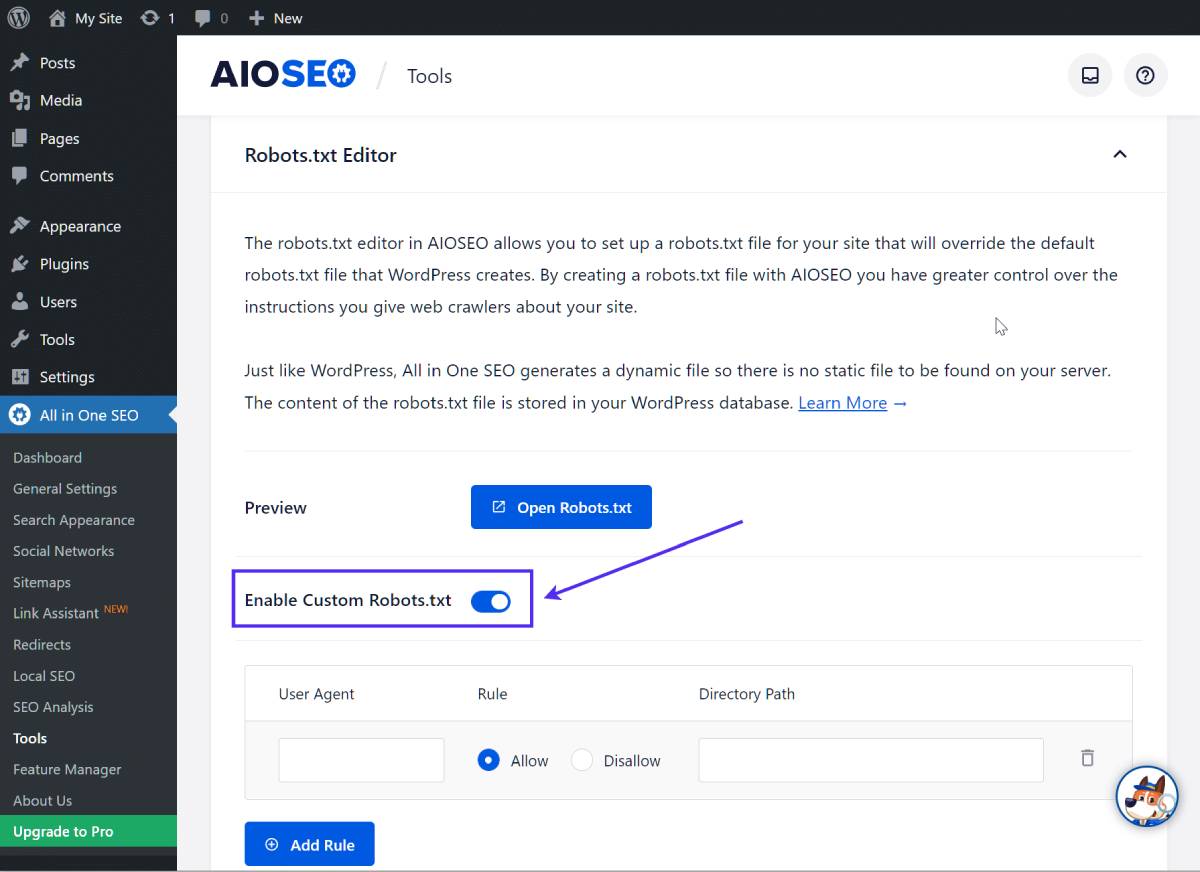

Để bắt đầu quá trình thiết lập các quy tắc tùy chỉnh hãy bật nút radio Enable Custom Robots.txt, sau đó tiến hành thêm chúng vào tệp robots.txt:

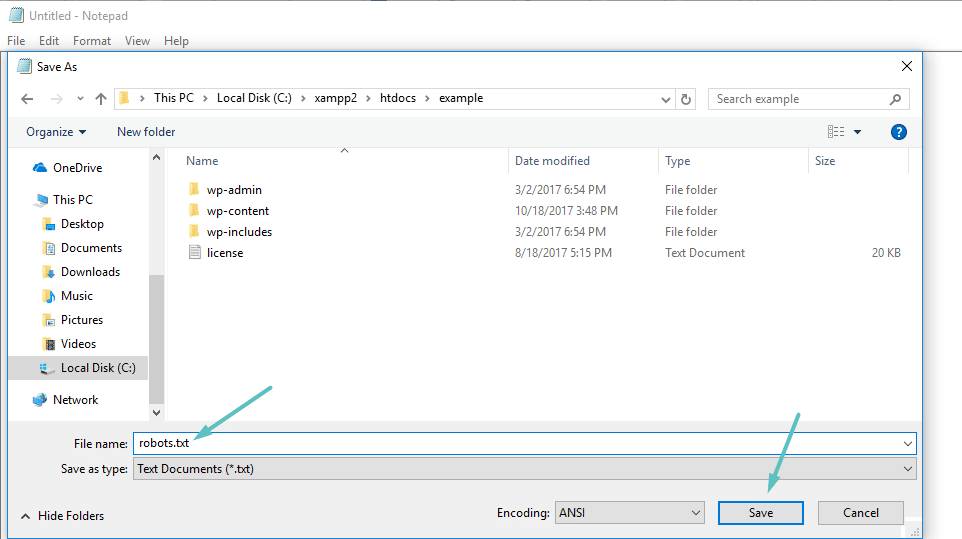

Tạo và chỉnh sửa tệp Robots.txt qua FTP

Ngoài plugin SEO, SFTP cũng có chức năng tạo và quản lý tệp Robots.txt. Để tạo một tệp Robots.txt mới có thể sử dụng các loại trình soạn thảo văn bản:

Hoàn tất quá trình tạo tệp cần kết nối với Website thông qua SFTP để tiến hành tải nó lên thư mục gốc hiện tại của trang web đó.

Những gì cần đưa vào file Robots.txt?

Tạo tệp Robot.txt vật lý trên máy chủ thành công, bây giờ bạn đã có thể chỉnh sửa và kiểm soát cách Robot tương tác với trang web của mình. Dưới đây là hai lệnh chính mà bạn có thể sử dụng:

- User-agent cho phép người dùng nhắm đến các bot cụ thể.

- Disallow có khả năng hạn chế Robot truy cập vào một số vị trí nhất định của Website.

Ngoài hai lệnh phổ biến trên, lệnh Allow cũng được ưa chuộng sử dụng rất phổ biến hiện nay. Thông thường, người dùng không nhất thiết phải sử dụng lệnh này bởi hầu hết các thành phần trên trang web đều được đánh dấu Allow mặc định. Nó có ích trong trường hợp người dùng muốn kích hoạt Disallow đối với một thư mục.

Người dùng có thể sử dụng hai lệnh Disallow/Allow để thực thi quá trình thêm bộ quy tắc mà User-agent được phép áp dụng. Hai lệnh Crawl-delay và Sitemap cũng được sử dụng nhưng chúng có một số vấn đề như sau:

- Trong trường hợp quá trình thu thập thông tin diễn ra chậm thì 2 lệnh này sẽ bị bỏ qua hoặc hiểu theo nhiều cách khác nhau.

- Đối với sơ đồ Website thì hai lệnh này được tạo ra bởi các công cụ như Google Search Console.

Hướng dẫn chặn quyền truy cập vào toàn bộ trang web

Lựa chọn thêm mã sau vào tệp robots.txt WordPress để có thể hạn chế tất cả các quyền truy cập của trình thu thập thông tin trên Website:

User-agent: * Disallow: /

Trong đó, dấu * của User-agent có nghĩa là tất cả các tác nhân của người dùng. Ký tự * là đại diện cho phép mọi User-agent. Dấu / biểu thị các quyền hạn chế truy cập vào các trang có chứa “yourdomain.com/”.

Chặn Bot truy cập trang web với Robots.txt

Trong đó, dấucủa User-agent có nghĩa là tất cả các tác nhân của người dùng. Ký tựlà đại diện cho phép mọi User-agent. Dấubiểu thị các quyền hạn chế truy cập vào các trang có chứa “yourdomain.com/”.

Để ngăn chặn việc Bing thu thập dữ liệu trên các Website hãy thay thế ký tự đại diện * bằng Bingbot:

User-agent: Bingbot Disallow: /

Đoạn mã trên đây cho biết người dùng chỉ có thể áp dụng quy tắc Disallow cho phép tất cả các Bot có User-agent “Bingbot”. Việc chặn quyền truy cập này sẽ làm cho các Bot không thu thập được các thông tin dữ liệu trên trang web.

Chặn quyền truy cập vào một thư mục hoặc tệp cụ thể với Robots.txt

Đoạn mã trên đây cho biết người dùng chỉ có thể áp dụng quy tắc Disallow cho phép tất cả các Bot có User-agent “Bingbot”. Việc chặn quyền truy cập này sẽ làm cho các Bot không thu thập được các thông tin dữ liệu trên trang web.

Để hạn chế quyền truy cập vào các tệp hay thư mục trên WordPress hoặc chặn toàn bộ thư mục wp-admin/wp-login.php có thể sử dụng lệnh sau:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-login.php

Cấp quyền truy cập vào một file cụ thể trong một thư mục không được phép với Robots.txt

Để hạn chế toàn bộ thư mục và chỉ cho phép truy cập vào một thư mục cụ thể trên tệp Robots.txt ảo của WordPress, hãy sử dụng lệnh Allow:

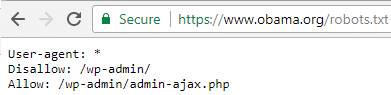

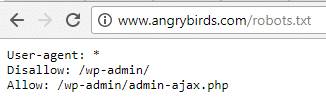

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Trong đó, đây là đoạn mã được sử dụng để hạn chế quyền truy cập vào toàn bộ thư mục /wp-admin/folder except for/wp-admin/admin-ajax.php.

Hạn chế lỗi thu thập thông tin kết quả tìm kiếm trên WordPress với Robots.txt

Trong đó, đây là đoạn mã được sử dụng để hạn chế quyền truy cập vào toàn bộ thư mục //folder

Bằng cách sử dụng tham số truy vấn “? S =” để ngăn trình thu thập thông tin tìm kiếm các dữ liệu trên trang của WordPress. Cụ thể hãy thêm các quy tắc vào lệnh sau:

User-agent: * Disallow: /?s= Disallow: /search/

Đây là một phương pháp khá hiệu quả giúp hạn chế lỗi soft 404.

Cách tạo các quy tắc trong Robots.txt cho các Bot khác nhau

Đây là một phương pháp khá hiệu quả giúp hạn chế lỗi soft 404.

Mặc dù hầu hết các quy tắc đều được xử lý cùng một lúc nhưng để áp dụng các quy tắc khác nhau cho các Bot khác nhau, thì chỉ cần bổ sung mỗi bộ quy tắc đó vào phần khai báo User-agent cụ thể của từng Bot. Ví dụ như để tạo một quy tắc mà có thể sử dụng cho cả Bot và một Bot chủ có thể sử dụng cho Bingbot, hãy thực hiện theo lệnh sau:

User-agent: * Disallow: /wp-admin/ User-agent: Bingbot Disallow: /

Trong ví dụ này, tất cả các Bot sẽ wp-admin/ và Bingbot sẽ bị chặn truy cập vào toàn bộ trang web.

Kiểm tra file Robots.txt

Trong ví dụ này, tất cả các Bot sẽ bị chặn truy cập // và Bingbot sẽ bị chặn truy cập vào toàn bộ trang web.

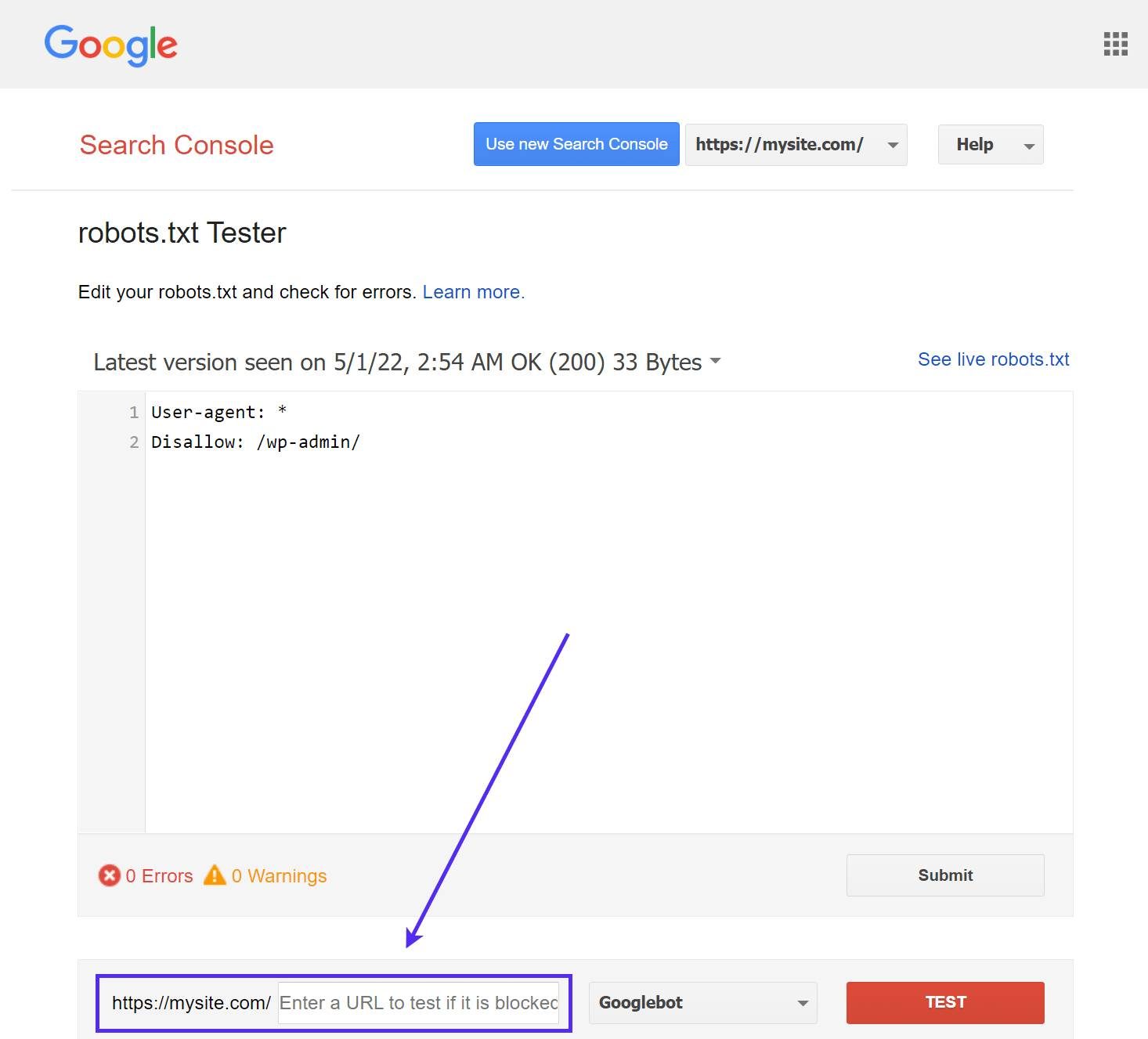

Hãy kiểm tra tệp Robots.txt trên WordPress để đảm bảo rằng chúng chính xác bằng cách sử dụng công cụ Google’s robots.txt Tester tool. Truy cập và mở thanh công cụ lên, sau đó hãy cuộn xuống cuối trang để nhập bất kỳ URL bao gồm cả trang chủ Website. Sau đó, nhấn chọn vào nút TEST có màu đỏ.

Nếu có thể bắt đầu thu thập thông tin, trên màn hình hiển thị sẽ gửi về phản hồi Allowed màu xanh lục. Bạn có thể kiểm tra từng URL cụ thể để đảm bảo rằng cũng đã bị chặn hay Disallowed.

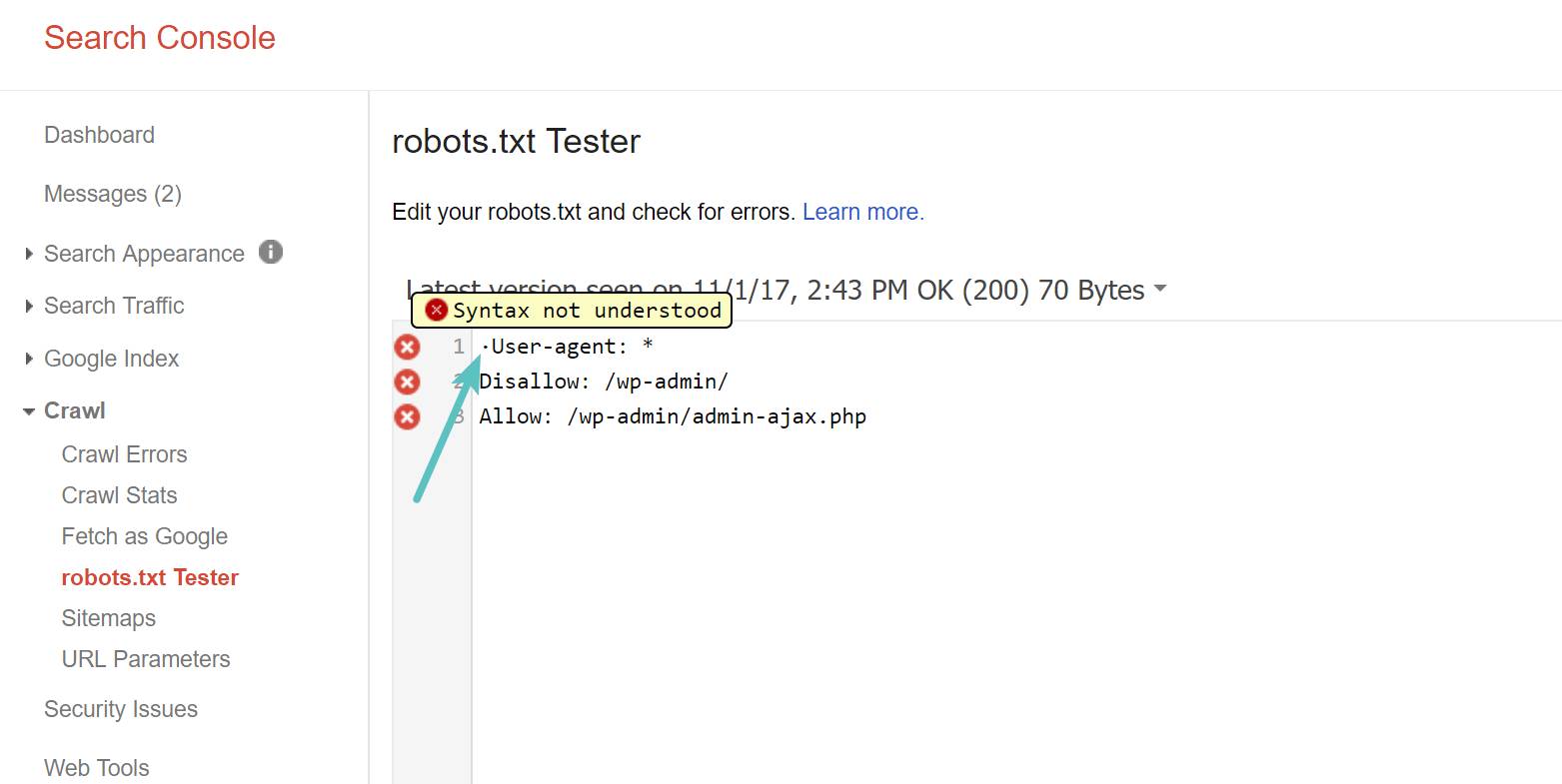

Một số lưu ý đối với UTF-8 BOM

BOM – Byte Order Mark được gọi là dấu thứ tự byte. Nó được sử dụng để bổ sung vào các tệp thông qua một số trình soạn thảo văn bản cũ và các công cụ phù hợp bất kỳ. Google sẽ không thể đọc chính xác các thông tin đối với các tệp Robots.txt. Do đó, việc kiểm tra tệp để tìm ra các lỗi và điều rất quan trọng.

Chẳng hạn như một tệp xuất hiện ký tự ẩn, Google sẽ phản hồi về việc không hiểu cú pháp khiến cho quá trình đọc lệnh của tệp Robots.txt không thể diễn ra.

Tại Hoa Kỳ luôn cho phép Googlebot hoạt động ngay cả khi khu vực cụ thể có thể bị nhắm mục tiêu thu thập dữ liệu cục bộ.

Một số WordPress Website phổ biến trong file Robots.txt

Một số các trang web WordPress được liệt kê trong Robots.txt như sau:

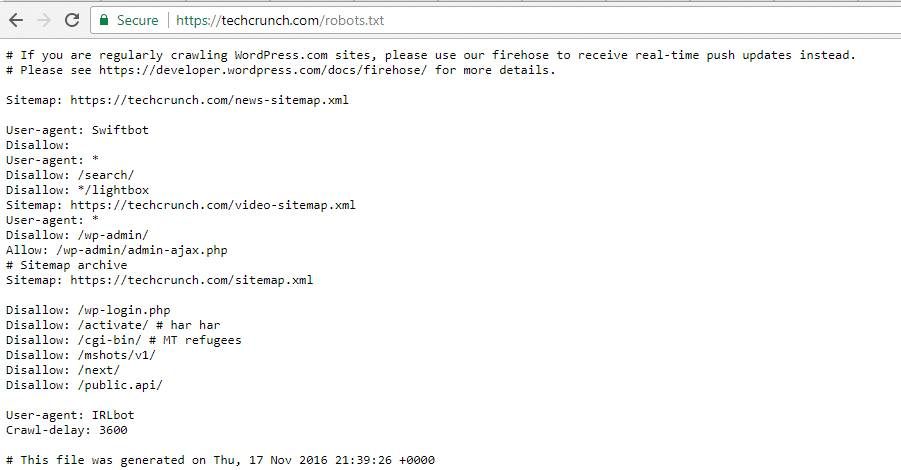

TechCrunch

TechCrunch luôn ngăn chặn các trình thu thập thông tin thu thập các dữ liệu của nó. Đồng thời, đối với Swiftbot và IRLbot thì TechCrunch cũng đặt ra các hạn chế đặc biệt.

The Obama Foundation

The Obama Foundation chỉ thực hiện giới hạn quyền truy cập vào /wp-admin/ mà không thực hiện bất kỳ bổ sung đặc biệt nào khác.

Angry Birds

Tương tự như The Obama Foundation, Angry Birds cũng có khả năng thiết lập mặc định và không có bất kỳ đặc biệt nào được thêm vào.

Drift

Drift được sử dụng để xác định các sơ đồ Website trong tệp Robots.txt. Hơn nữa, nó còn có tính năng hạn chế mặc định tương tự như The Obama Foundation và Angry Birds.

Sử dụng Robots.txt như thế nào?

Không giống với cách sử dụng thẻ Noindex, lệnh Disallow trong tệp Robots.txt có quy tắc sử dụng riêng. Đó là nó có thể hạn chế trình thu thập thông tin mà không bắt buộc thực hiện Index. Do đó, lập trình viên thường xuyên sử dụng Robots.txt để bổ sung các quy tắc nhất định. Điều này giúp định hình cách các công cụ tìm kiếm và Bot tương tác với trang web một cách dễ dàng. Tuy nhiên, nó sẽ không có khả năng kiểm soát các nội dung có được Index hay không.

Thông thường, những người dùng WordPress sẽ không cần thiết phải sửa đổi tệp Robots.txt ảo được cài đặt mặc định trên hệ thống. Trong trường hợp xảy ra các sự cố với Bot hoặc người dùng muốn thay đổi cách các công cụ tìm kiếm tương tác với plugin. Thì họ có thể lựa chọn phương pháp sử dụng các quy tắc của riêng mình.

Tổng kết

Hy vọng qua đây bạn đọc đã nắm được cách tạo và chỉnh sửa file WordPress Robots.txt hiệu quả với những công cụ hữu ích hỗ trợ thay thế và tìm ra các lỗi với Bot nhanh chóng.

Nếu còn gặp bất cứ vướng mắc gì về nội dung bài viết trên hoặc muốn tìm hiểu thêm những thông tin khác liên quan tới WordPress, hãy để lại ở bên bình luận bên dưới, BKHOST sẽ trả lời bạn trong thời gian sớm nhất.

P/s: Bạn cũng có thể truy cập vào Blog của BKHOST để đọc thêm các bài viết chia sẻ kiến thức về lập trình, quản trị mạng, website, domain, hosting, vps, server, email,… Chúc bạn thành công.

- tạo file robots txt cho wordpress

- hướng dẫn tạo file robots txt

- wordpress robots

Đăng ký dịch vụ Hosting Giá Rẻ tại BKHOST

BKHOST đang có chương trình khuyến mãi cực shock dành cho khách hàng đăng ký dịch vụ Hosting Giá Rẻ:

- Giảm giá lên đến

40%

.

- Chỉ từ

9k

/tháng.

- Tặng thêm gói bảo mật SSL Let’s Encrypt.

Đăng ký ngay:

Thuê hosting giá rẻ