Tối ưu hóa file robots.txt WordPress để cải thiện SEO là mông muốn của bất cừ người dùng WordPress nào. File Robots.txt cho các công cụ tìm kiếm biết cách thu thập dữ liệu trang web của bạn, điều này đã giúp nó trở thành một công cụ SEO cực kỳ hữu ích. Trong bài viết này, vietnix sẽ hướng dẫn bạn cách tạo một file robots.txt WordPress hoàn hảo cho SEO.

Tóm Tắt

File robots.txt là gì?

Robots.txt là một file text tạo để cho các bot của công cụ tìm kiếm biết cách thu thập thông tin và indexing trang trên trang web của họ, nó thường được lưu trữ trong thư mục gốc còn được gọi là thư mục chính của trang web của bạn, định dạng cơ bản cho file robots.txt như sau:

1234567User-agent: [user-agent name]Disallow: [URL string not to be crawled] User-agent: [user-agent name]Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

robots.txt là gì?

robots.txt là gì?

Xem thêm: User Agent là gì? Cách thay đổi UA trên Chrome, Safari, Firefox và Microsoft Edge

Nếu bạn không cho phép một URL thì các bot của công cụ tìm kiếm sẽ tự hiểu rằng chúng được phép thu thập dữ liệu đó.

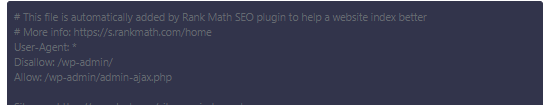

Đây là file ví dụ robots.txt tương tự như sau:

123456User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

Trong ví dụ robots.txt ở trên admin đã cho phép các công cụ tìm kiếm thu thập thông tin và indexing các file trong thư mục upload WordPress trên website. Ngoài ra, admin đã không cho phép các bot tìm kiếm thu thập thông tin và indexing các plugin cũng như thư mục quản trị WordPress.

Cuối cùng, chúng tôi đã cung cấp URL sơ đồ trang XML của chúng tôi.

Bạn có cần file Robots.txt cho trang web WordPress của mình không?

Nếu bạn không có file robots.txt thì các công cụ tìm kiếm vẫn sẽ thu thập thông tin và indexing trang web của bạn. Tuy nhiên, bạn sẽ không thể cho các công cụ tìm kiếm biết trang hoặc thư mục nào mà chúng không nên thu thập thông tin.

robots.txt WordPress

robots.txt WordPress

Sẽ không có nhiều tác động khi bạn mới bắt đầu viết blog và chưa có nhiều nội dung. Tuy nhiên, khi trang web của bạn phát triển và có nhiều nội dung thì bạn nên kiểm soát tốt hơn cách trang web của bạn được thu thập thông tin và indexing. Đó là lý do tại sao mà chúng ta cần phải có một hạn ngạch thu thập thông tin cho các bot tìm kiếm trên mỗi trang web.

Nếu các bot thu thập thông tin một số trang nhất định trong một phiên thu thập thông tin. Khi đó, nếu việc thu thập thông tin tất cả các trang trên trang web của bạn chua hoàn thành, thì bot sẽ quay lại và tiếp tục thu thập thông tin trong phiên tiếp theo. Việc này có thể làm chậm tốc độ indexing trang web của bạn.

Bạn có thể khắc phục điều này bằng cách không cho phép các chương trình tìm kiếm cố gắng thu thập dữ liệu các trang không cần thiết như các trang quản trị WordPress, file plugin và thư mục theme của bạn. Bằng cách không cho phép các trang không cần thiết, bạn sẽ tiết kiệm được hạn ngạch thu thập thông tin của mình. Điều này giúp các công cụ tìm kiếm thu thập dữ liệu nhiều trang hơn trên trang web của bạn và indexing chúng nhanh nhất có thể.

File Robots.txt lý tưởng trông như thế nào?

Nhiều blog nổi tiếng sử dụng file robots.txt rất đơn giản, nội dung của chúng có thể khác nhau tùy thuộc vào nhu cầu của từng trang web cụ thể. Tuy đây không phải là cách an toàn nhất để ẩn nội dung khỏi người dùng nhưng nó sẽ giúp bạn ngăn nội dung xuất hiện trong kết quả tìm kiếm.

12345User-agent: *Disallow: Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xml

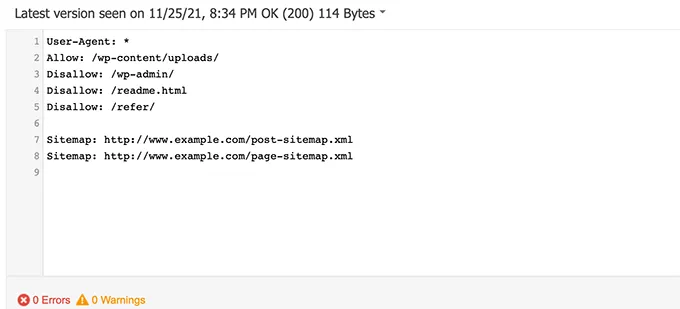

File robots.txt này cho phép tất cả các bot indexing tất cả nội dung và cung cấp cho chúng liên kết đến các sơ đồ trang XML của trang web. Đối với các trang web WordPress, bạn cần nắm rõ các quy tắc sau trong file robots.txt:

12345678User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xml

Điều này yêu cầu các bot tìm kiếm indexing tất cả các hình ảnh và file WordPress, nó không cho phép các bot tìm kiếm indexing khu vực quản trị WordPress, file readme và các liên kết liên kết được ẩn đi.

Bằng cách thêm các sơ đồ trang web vào file robots.txt, bạn sẽ giúp các bot của Google dễ dàng tìm thấy tất cả các trang trên trang web của bạn.

Như vậy là bạn đã biết file robots.txt lý trông lý tưởng như thế nào rồi đúng không, giờ hãy cùng xem cách mà bạn có thể tạo file robots.txt như thế nào trong WordPress.

Cách tạo file Robots.txt WordPress?

Có hai cách để tạo file robots.txt trong WordPress và bạn có thể chọn phương pháp phù hợp nhất với mình. 2 cách này bao gồm sử dụng plugin AOISEO và ứng dụng FTP.

Chỉnh sửa file Robots.txt bằng SEO tất cả trong một (All in One SEO).

All in One SEO còn được gọi là AIOSEO là mọt trong những plugin SEO cho WordPress tốt nhất trên thị trường với hơn 2 triệu trang web đang dùng, nó rất dễ sử dụng và đi kèm với nó là trình tạo file robots.txt.

Trang chủ AIOSEO

Trang chủ AIOSEO

Nếu bạn chưa biết cách cài đặt plugin AIOSEO thì bạn có thể xem hướng dẫn từng bước của chúng tôi về cách cài đặt plugin WordPress.

Lưu ý: Phiên bản miễn phí của AIOSEO có sẵn và có tính năng này.

Sau khi cài đặt và kích hoạt plugin, bạn có thể sử dụng plugin này để tạo và chỉnh sửa file robots.txt của mình trực tiếp từ khu vực quản trị viên WordPress của bạn.

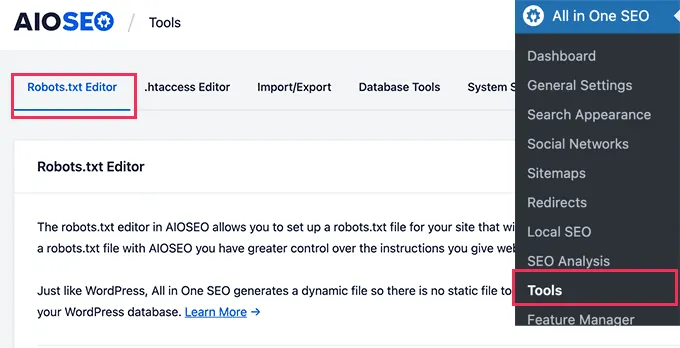

Chỉ cần đi tới All in One SEO » Tools để chỉnh sửa file robots.txt của bạn.

robots.txt AIO SEO

robots.txt AIO SEO

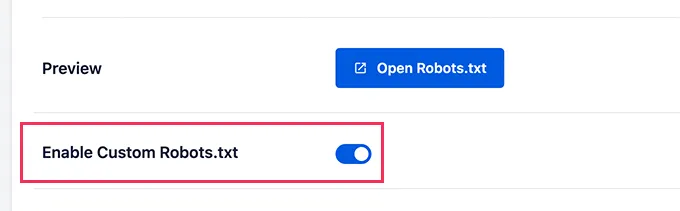

Trước tiên, bạn cần bật tùy chọn chỉnh sửa bằng cách click vào nút chuyển đổi ‘Enable Custom Robots.txt’ sang màu xanh lam. Khi bật nút này, bạn có thể tạo file robots.txt tùy chỉnh trong WordPress.

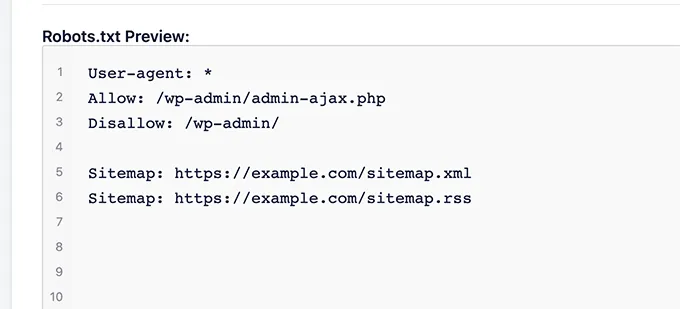

All in One SEO sẽ hiển thị file robots.txt hiện có của bạn trong phần ‘Robots.txt Preview’ ở cuối màn hình của bạn.

Phiên bản này sẽ hiển thị các quy tắc mặc định đã được WordPress thêm vào.

Các quy tắc mặc định này yêu cầu các công cụ tìm kiếm không thu thập dữ liệu các file WordPress cốt lõi của bạn, nó cho phép các bot index tất cả nội dung và cung cấp cho chúng liên kết đến các sơ đồ trang XML của trang web của bạn.

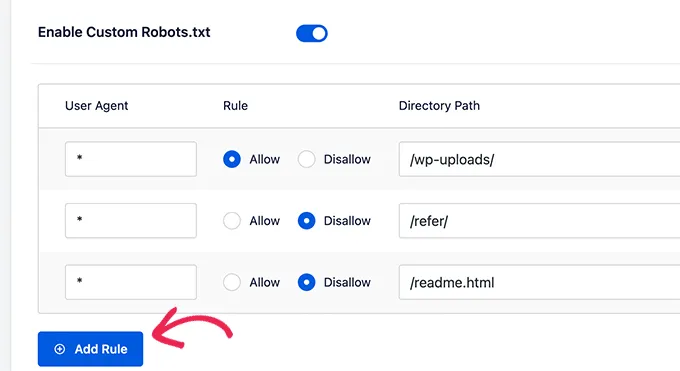

Bây giờ bạn có thể thêm các quy tắc tùy chỉnh của riêng mình để cải thiện file robots.txt cho SEO, để thêm quy tắc bạn hãy nhập agent người dùng vào trường ” User Agent”, sử dụng dấu * sẽ áp dụng quy tắc cho tất cả các agent người dùng. Sau đó, bạn có thể chọn ‘Allow’ hoặc ‘Disallow’ các công cụ tìm kiếm thu thập thông tin, tiếp theo nhập tên file hoặc đường dẫn thư mục vào trường ‘Directory Path’.

Add rule cho file rotbots.txt

Add rule cho file rotbots.txt

Quy tắc sẽ tự động được áp dụng cho robots.txt của bạn, để thêm một quy tắc khác, hãy nhấp vào nút ‘Add Rule’. Chúng tôi khuyên bạn nên thêm các quy tắc cho đến khi bạn tạo ra được định dạng robots.txt lý tưởng mà chúng tôi đã chia sẻ ở trên.

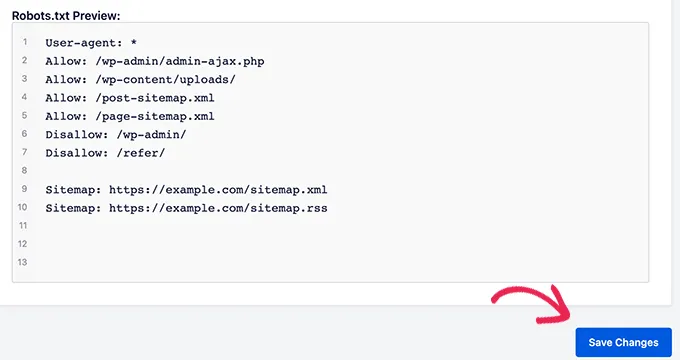

Các quy tắc tùy chỉnh của bạn sẽ được hiển thị tương tự như sau:

Sau khi hoàn tất, đừng quên nhấp vào nút ” Save Changes ” để lưu trữ các thay đổi của bạn.

Chỉnh sửa file Robots.txt theo cách thủ công bằng FTP

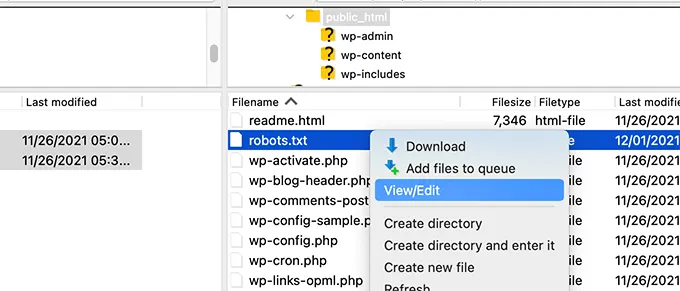

Đối với phương pháp này, bạn sẽ cần sử dụng ứng dụng FTP client để chỉnh sửa file robots.txt.

Chỉ cần kết nối với tài khoản lưu trữ WordPress của bạn bằng ứng dụng FTP. Khi vào bên trong, bạn sẽ có thể thấy file robots.txt trong thư mục gốc của trang web của bạn.

Kiểm tra file robots.txt trên FTP

Kiểm tra file robots.txt trên FTP

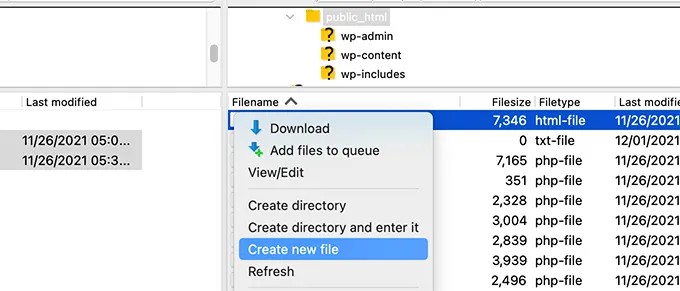

Nếu bạn không nhìn thấy file thì có thể bạn không có file robots.txt nào, trong trường hợp này bạn vẫn có thể tiếp tục và tạo một file mới.

Tạo mới file robots.txt trên FTP

Tạo mới file robots.txt trên FTP

Robots.txt là một file text thuần túy, có nghĩa là bạn có thể download nó xuống máy tính của mình và chỉnh sửa bằng bất kỳ trình soạn thảo văn bản thuần túy nào như Notepad hoặc TextEdit. Sau khi lưu các thay đổi, bạn có thể load nó trở lại thư mục gốc của trang web.

Làm thế nào để kiểm tra tệp Robots.txt của bạn?

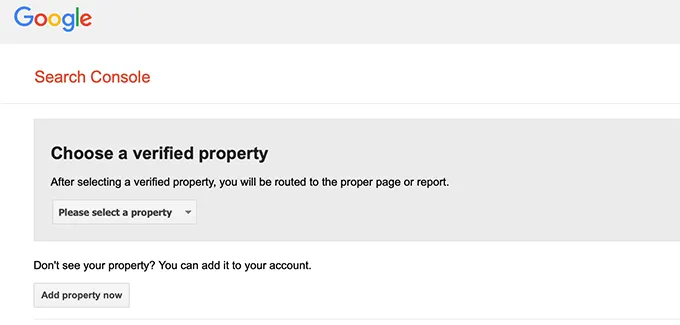

Sau khi bạn đã tạo file robots.txt của mình, bạn nên kiểm tra file đó bằng công cụ trình kiểm tra robots.txt, có rất nhiều công cụ kiểm tra robots.txt trên mạng nhưng chúng tôi khuyên bạn nên sử dụng công cụ bên trong Google Search Console.

Trước tiên, bạn cần phải liên kết trang web của mình với Google Search Console, nếu bạn chưa làm điều này thì bạn hãy xem hướng dẫn của chúng tôi về cách thêm trang web WordPress của bạn vào Google Search Console. Sau đó, bạn có thể sử dụng Tool kiểm tra robot của Google Search Console.

Kiên tra file robots.txt trên Google Search Console

Kiên tra file robots.txt trên Google Search Console

Chỉ cần chọn property của bạn từ danh sách thả xuống, công cụ sẽ tự động tìm nạp file robots.txt của trang web của bạn và đánh dấu các lỗi và đưa ra lời cảnh báo nếu có.

Mục tiêu của việc tối ưu hóa file robots.txt của bạn là để ngăn các công cụ tìm kiếm thu thập dữ liệu các trang hiện không công khai. Ví dụ: các trang trong thư mục wp-plugins hoặc các trang trong thư mục quản trị viên WordPress của bạn.

Một sai lầm phổ biến giữa các chuyên gia SEO là việc chặn category, thẻ và trang lưu trữ của WordPress sẽ giúp cải thiện tốc độ thu thập dữ liệu và dẫn đến việc indexing nhanh hơn và xếp hạng cao hơn. Nhưng đó không phải là cách đúng mà nó còn chống lại các nguyên tắc quản trị trang web của Google. Bạn nên làm theo định dạng robots.txt ở trên để tạo file robots.txt an toàn cho trang web của bạn.

Lời kết

Vietnix hy vọng bài viết này đã giúp ích cho bạn nhiều hơn trong việc tối ưu hóa file robots.txt WordPress để cải thiện SEO cho website của mình. Nếu bạn có bất cứ thắc mắc gì, hãy comment ở phía bên fuowis bài viết để Vietnix hỗ trợ nhé.